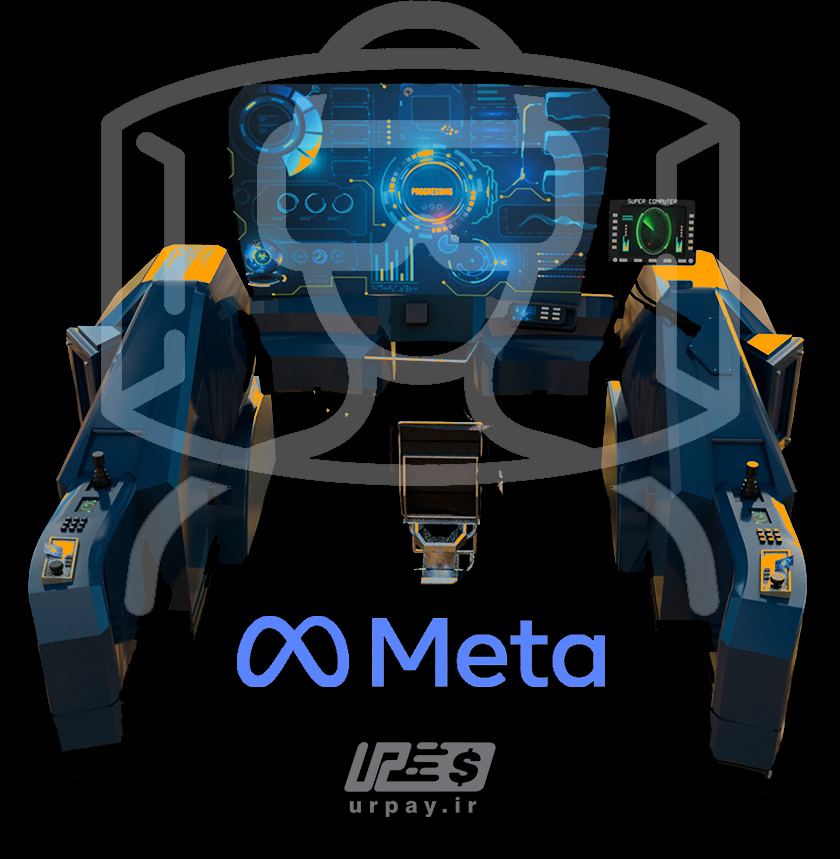

ابرکامپیوتر هوش مصنوعی متا، راه را برای ساخت متاورس باز میکند

ابرکامپیوتر هوش مصنوعی متا، راه را برای ساخت متاورس باز میکند.

شرکت بزرگ متا (فیسبوک) از برنامههای خود برای ساخت یک ابررایانه هوش مصنوعی قدرتمند به نام SuperCluster تحقیقاتی هوش مصنوعی (RSC) رونمایی کرده است. متا ادعا میکند در حال حاضر یکی از سریعترین ابررایانههای این چنینی در جهان است. این شرکت اعلام کرد که این سریعترین ابررایانه هوش مصنوعی در جهان خواهد بود که تا اواسط سال 2022 تکمیل میشود.

به گفته متا، RSC برای ساخت مدلهای هوش مصنوعی با قابلیت یادگیری از تریلیونها نمونه و کار در زبانهای مختلف استفاده خواهد شد. این ابررایانه همچنین ابزارهای واقعیت افزوده جدیدی را برای تجزیه و تحلیل متن، تصاویر و ویدئوها توسعه خواهد داد که میتواند برای تشخیص الفاظ رکیک و اخبار جعلی در برنامههای فیسبوک استفاده شود.

از RSC برای توسعه متاورس نیز استفاده خواهد شد؛ متا در این مورد میگوید: در نهایت، کار انجام شده با RSC، راه را به سوی فناوری ساخت، پلتفرم محاسباتی بزرگ بعدی هموار میکند. در متاورس برنامهها و محصولات مبتنی بر هوش مصنوعی نقش مهمی ایفا خواهند کرد.

هوش مصنوعی، در حال حاضر برای ترجمه متن بین زبانها و شناسایی محتوای ممنوع یا مضر استفاده میشود. با این حال، برای انجام چنین وظایفی در این مقیاس، به ابررایانه های هوش مصنوعی نیاز است. به طور خلاصه، ابررایانههای هوش مصنوعی، رایانههای پرسرعتی هستند که برای آموزش مدلهای هوش مصنوعی و سیستمهای یادگیری ماشینی استفاده میشوند.

متا گفت: «با RSC، ما میتوانیم مدلهایی را با سرعت بیشتری آموزش دهیم که از سیگنالهای چندوجهی برای تعیین مضر یا خوب بودن یک عمل، صدا یا تصویر استفاده میکنند. “این تحقیق نه تنها به حفظ امنیت مردم در خدمات امروزی ما کمک می کند، بلکه در آینده، در متاورس به کار میرود.”

Meta ظاهراً قصد دارد با استفاده از این رایانه متمرکز، متاورس را توسعه دهد. این با اخلاق اصلی کریپتو در عدم تمرکز مطابقت ندارد و این دلیلی است که جامعه نسبت به ساخت متاورس خوشبین نیست.

از نظر قدرت پردازش، فاز یک RSC، در حال اجرا است. “در کل 760 سیستم NVIDIA DGX A100 به عنوان گرههای محاسباتی آن، برای مجموع 6080 واحد پردازش گرافیکی است که هر واحد پردازش گرافیکی A100 بیشتر است. قدرتمندتر از V100 مورد استفاده در سیستم قبلی. اما زمانی که فاز دو رایانه راه اندازی شود؛ انتظار میرود که حدود 16000 پردازنده گرافیکی باشد و میتواند سیستمهای هوش مصنوعی را «با بیش از یک تریلیون پارامتر در مجموعه دادههایی به بزرگی یک اگزابایت» آموزش دهد.